Negli ultimi tempi e con sempre maggiore rapidità, si sta diffondendo un nuovo strumento per manipolare l’informazione: i video deepfake.

Tutto nacque nel luglio 2017 quando già l’Economist descrisse questi video come un fenomeno che, attraverso l’utilizzo di un codice informato, è in grado di modificare audio e riprese per far dire o fare a una o più persone cose mai avvenute nella realtà. Un esempio concreto è stato mostrato poco tempo fa in una puntata di Striscia La Notizia. Il falso video rivelava un improbabile fuorionda di Matteo Renzi in cui il leader di Italia Viva commentava poco piacevolmente il Presidente del Consiglio Giuseppe Conte e il Presidente della Repubblica Sergio Mattarella. Le affermazioni ovviamente erano false, così come il video stesso. Ma come funzionano i deepfake?

Prendendo il caso specifico, sono state girate delle scene durante le quali un attore ha pronunciato tutte le frasi incriminate al Matteo Renzi del video finale reso noto dal programma televisivo. Successivamente, grazie a un algoritmo che funziona con il deep learning, una branca dell’intelligenza artificiale che fa riferimento agli algoritmi ispirati alla struttura e alla funzione del cervello e si basa sull’assimilazione di rappresentazioni di dati come il riconoscimento automatico della lingua parlata, l’elaborazione del linguaggio naturale e il riconoscimento audio, all’attore protagonista sono stati sostituiti il volto e la voce con quelli della persona a cui si intendeva far dire determinate cose creando così un video falso. In questo caso, il filmato aveva lo scopo di manipolare la voce e il volto di Matteo Renzi al fine di far circolare delle sue critiche, anche piuttosto aspre, nei confronti di alcune delle cariche più importanti dello Stato.

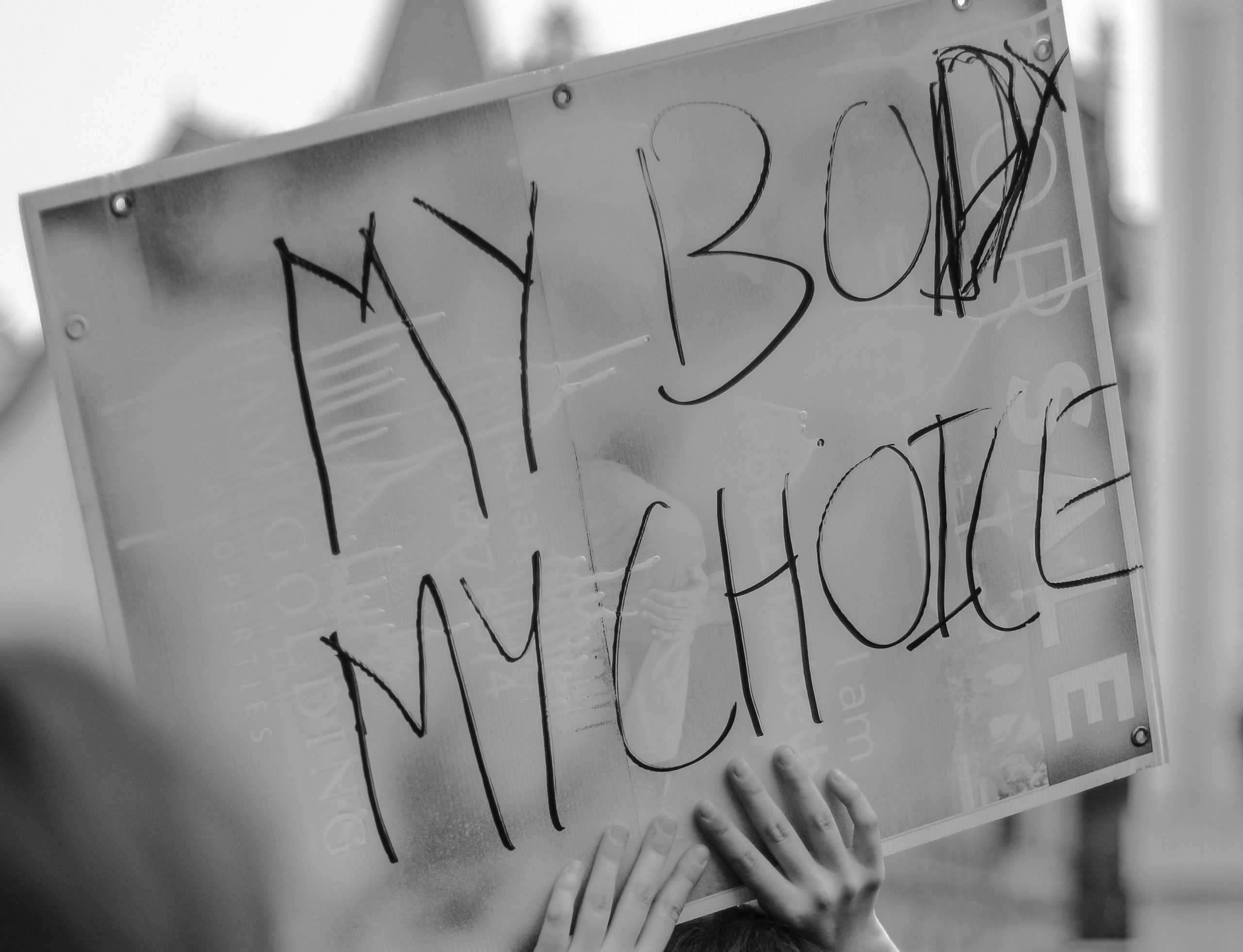

I deepfake rappresentano, dunque, una distorsione della realtà, dei video manipolati attraverso l’intelligenza artificiale che hanno il solo fine, almeno apparentemente, di screditare l’immagine di qualcuno. Un episodio negativo causato da questo fenomeno – e raccontato da il Post – è accaduto in India dove la giornalista Rana Ayyub, in seguito a un fatto di cronaca, ha sostenuto attraverso il suo profilo Twitter che il governo del suo Paese stesse difendendo degli stupratori. In seguito a questa dichiarazione, sui social hanno iniziato a circolare falsi tweet in cui la Ayyub affermava di odiare l’India e gli indiani ma anche un video porno in cui il volto della giornalista veniva sostituito a quello dell’attrice del corto originale. Lo scopo, chiaramente, era quello di mettere a tacere la cronista e infatti, in una dichiarazione rilasciata all’Huffington Post dopo la tempesta mediatica che l’ha vista protagonista, la stessa Rana Ayyub ha ammesso di aver gradualmente smesso di esprimere le sue opinioni in pubblico.

Il problema principale è che i video fasulli sono difficili da individuare e contribuiscono così a compromettere il mondo dell’informazione, già saturo di notizie e di articoli inutilmente prolissi. Il Wall Street Journal, a questo proposito, ha creato un sistema per esaminare i deepfake e formare i suoi giornalisti a riconoscerli. Inoltre, per gli addetti del settore, si possono utilizzare numerosi programmi di montaggio per ingrandire le immagini e capire se ci sono state manipolazioni. Ciò che è certamente necessario per contrastare questa nuova minaccia, così come le cosiddette bufale, resta comunque sempre il controllo delle fonti, sia da parte di chi si occupa di fare informazione, sia di chi invece naviga sul web e, soprattutto, sui social.

Sappiamo oramai come le fake news vengano create appositamente per screditare, soprattutto in politica, la parte ideologicamente contrapposta per ottenere maggiore consenso oppure per contraffare i risultati delle proprie azioni di governo dando letteralmente i numeri, come nel caso degli sbarchi a Lampedusa che risultano essere pochi o tanti in base a chi rende noti i dati. Lo scopo è principalmente quello di calunniare qualcuno agli occhi dell’opinione pubblica. I deepfake, inoltre, hanno un ulteriore compito: possono addirittura far perdere la dignità o limitare la libertà di espressione come si evince dalla storia della giornalista indiana. Non è un caso, infatti, che essi nascano per far sovrapporre ai volti delle attrici di video pornografici quelli di celebrità del mondo dello spettacolo. Il 96% dei deepfake esistenti, di fatti, è di questo genere.

Con una minaccia simile, dunque, diventa difficile distinguere il confine tra vero e falso, propinando così diffidenza tra le persone. Questa nuova tecnologia di intelligenza artificiale si conferma di certo avanguardista ma, visto come potrebbe rivoluzionare la nostra società, non si può certo definire progressista.